이번 수요일(2025년 3월 12일)에 발표되었습니다. 1B, 4B, 12B, 27B의 4가지 크기로 출시되었으며, 사전 학습된 버전과 지침 미세 조정된 버전이 있습니다. 모델 4B, 12B, 27B는 확장된 컨텍스트 창(최대 128K)과 다중 모달리티를 제공합니다.

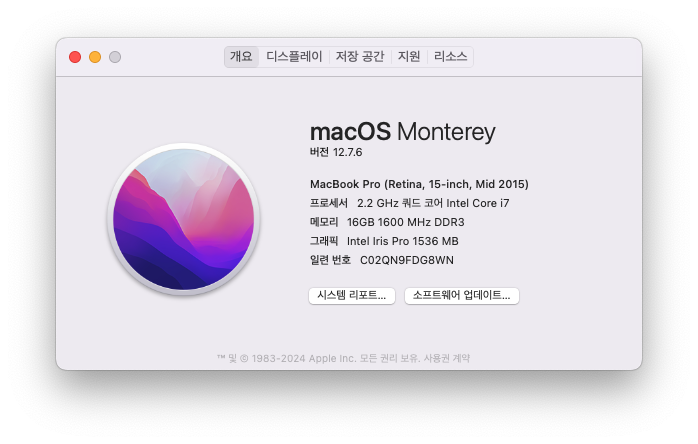

Macbook M1 + Ollama + gemma3 로 Multimodal 이미지 처리를 테스트해보겠습니다

Gemma is a lightweight, family of models from Google built on Gemini technology. The Gemma 3 models are multimodal—processing text and images—and feature a 128K context window with support for over 140 languages. Available in 1B, 4B, 12B, and 27B parameter sizes, they excel in tasks like question answering, summarization, and reasoning, while their compact design allows deployment on resource-limited devices.

Gemma는 Google이 Gemini 기술을 기반으로 개발한 경량 모델 계열입니다. Gemma 3 모델은 멀티모달 모델로, 텍스트와 이미지를 처리할 수 있으며 128K 컨텍스트 윈도우를 제공하고 140개 이상의 언어를 지원합니다. 1B, 4B, 12B, 27B 파라미터 크기로 제공되며, 질문 응답, 요약, 추론과 같은 작업에서 뛰어난 성능을 발휘합니다. 또한, 컴팩트한 설계로 인해 자원이 제한된 장치에서도 실행할 수 있습니다.

더욱 상세한 모델 설명을 보고자 한다면 "Gemma 3 기술 보고서 PDF"를 참고하세요.

Models

Text

- 1B parameter model (32k context window)

Multimodal (Vision)

- 4B parameter model (128k context window)

- 12B parameter model (128k context window)

- 27B parameter model (128k context window)

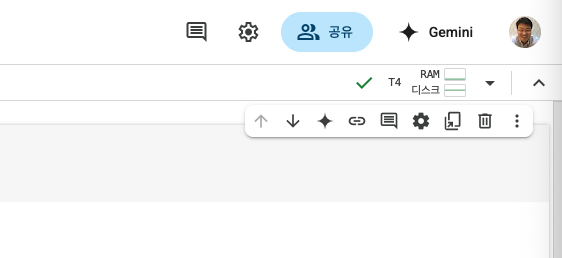

Default 모델은 4B 모델이고 1B는 text 이고 4B 사이즈부터 Multimodal 모델입니다. 4B 모델을 받습니다.

ollama run gemma3:4b

dongsik@dongsikleeui-MacBookPro % ollama run gemma3:4b

pulling manifest

pulling 377655e65351... 100% ▕█████████████████████████████████████████████████▏ 3.3 GB

pulling e0a42594d802... 100% ▕█████████████████████████████████████████████████▏ 358 B

pulling dd084c7d92a3... 100% ▕█████████████████████████████████████████████████▏ 8.4 KB

pulling 0a74a8735bf3... 100% ▕█████████████████████████████████████████████████▏ 55 B

pulling ffae984acbea... 100% ▕█████████████████████████████████████████████████▏ 489 B

verifying sha256 digest

writing manifest

success

>>> Send a message (/? for help)

설치 확인

dongsik@dongsikleeui-MacBookPro % ollama --version

ollama version is 0.6.0

dongsik@dongsikleeui-MacBookPro % ollama list

NAME ID SIZE MODIFIED

gemma3:4b c0494fe00251 3.3 GB 41 minutes ago

dongsik@dongsikleeui-MacBookPro %

첫번째 이미지 분석입니다.

멋지고 쿨한 선글라스를 쓴 3마리 고양이입니다.

사진에서 어떤 설명을 하는지 먼저 볼까요? 우선 영어로 질문해보겠습니다 "Describe what you see in this picture"

dongsik@dongsikleeui-MacBookPro % ollama run gemma3:4b

>>> Describe what you see in this picture vecteezy_three-cool-cats.jpg

Okay, I've analyzed the image vecteezy_three-cool-cats.jpg. Here's a description of what I see:

**Overall Impression:**

The image is a playful and vibrant digital illustration featuring three stylized cats.

It has a cartoonish, slightly retro feel, likely intended for a fun or whimsical design.

**Detailed Description:**

* **Subject:** There are three cats, each with a distinct style.

* **Cat 1 (Left):** This cat is a bright, almost neon blue with a sleek, modern design.

It has large, expressive eyes and a confident pose, looking directly at the viewer.

* **Cat 2 (Center):** This cat is a vibrant pink with a more rounded, friendly appearance.

It has a slightly mischievous expression and is playfully leaning forward.

* **Cat 3 (Right):** This cat is a bright yellow with a more geometric, almost robotic-looking

design. It has a slightly tilted head and a curious expression.

* **Style:** The illustration is clearly digital and stylized.

The lines are clean and bold, and the colors are saturated.

It resembles a vector graphic, which means it can be scaled up or down without losing quality.

* **Background:** The background is a solid, dark gray, which helps the bright colors of the cats

to pop.

* **Composition:** The cats are arranged in a horizontal line, with the central cat slightly closer

to the viewer.

* **Overall Tone:** The image has a cheerful and energetic tone. It's designed to be appealing and fun.

**In essence, it's a cute and colorful digital illustration of three stylized cats,

likely intended for use in a graphic design project.**

Would you like me to focus on a specific aspect of the image, such as the style, color palette,

or potential uses for this illustration?

>>> Send a message (/? for help)

Macbook M1에서 처리속도는 꽤 빠릅니다. 최초 질문에 응답하는데 20초 정도에 위 설명을 마쳤습니다.

>>> 이 그림에서 보이는 것을 한글로 설명하세요 vecteezy_three-cool-cats.jpg

네, vecteezy_three-cool-cats.jpg 그림에 보이는 것을 설명해 드리겠습니다.

이 그림은 세 마리의 귀여운 고양이 그림입니다. 각 고양이는 다른 색깔과 스타일을 가지고 있습니다.

* **왼쪽 고양이:** 밝은 파란색으로, 세련되고 현대적인 느낌을 줍니다. 눈이 크고 자신감 있는 표정을 짓고 있습니다.

* **중간 고양이:** 밝은 분홍색으로, 둥글고 친근한 느낌을 줍니다. 장난기 넘치는 표정으로 앞으로 기대어 있습니다.

* **오른쪽 고양이:** 밝은 노란색으로, 기하학적인 디자인을 하고 있습니다. 머리를 살짝 기울여 호기심 있는 표정을 짓고 있습니다.

전체적으로 디지털 그림이며, 선이 깔끔하고 색상이 강렬하게 표현되어 있습니다. 배경은 어두운 회색으로, 고양이들의 색깔을 더욱 돋보이게 합니다.

전반적으로 귀엽고 활기찬 느낌을 주는 그림입니다.

혹시 그림의 특정 부분에 대해 더 자세한 설명을 원하시면 말씀해주세요.

>>> Send a message (/? for help)

오른쪽 고양이의 썬글라스 색을 물어봤는데 제눈에는 노란색으로 보입니다. gemma3는 밝은 금색(Gold) 라고 합니다.

아마 저색이 금색이겠죠?

>>> 이 그림에서 오른쪽 고양이의 썬글라스 색깔을 알려주세요 vecteezy_three-cool-cats.jpg

오른쪽 고양이의 썬글라스 색깔은 **금색 (Gold)** 입니다.

사진을 자세히 살펴보니, 썬글라스 렌즈와 프레임이 모두 밝은 금색으로 되어 있습니다.

>>> Send a message (/? for help)

>>> Please tell me the color of the sunglasses on the cat on the right in this picture. vecteezy_three-cool-cats.jpg

The sunglasses on the cat on the right are **gold**. They have a bright, metallic gold color.

>>>

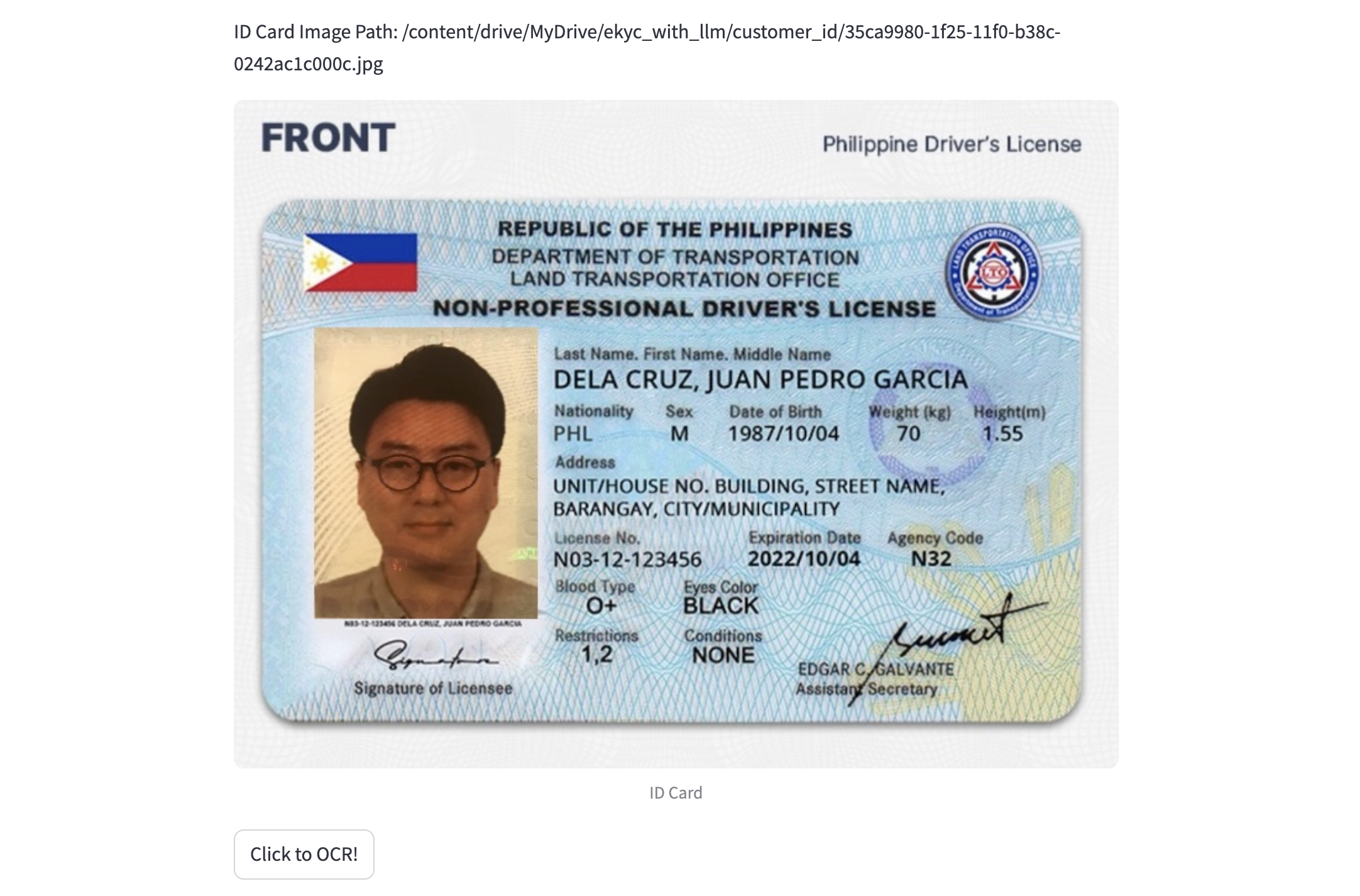

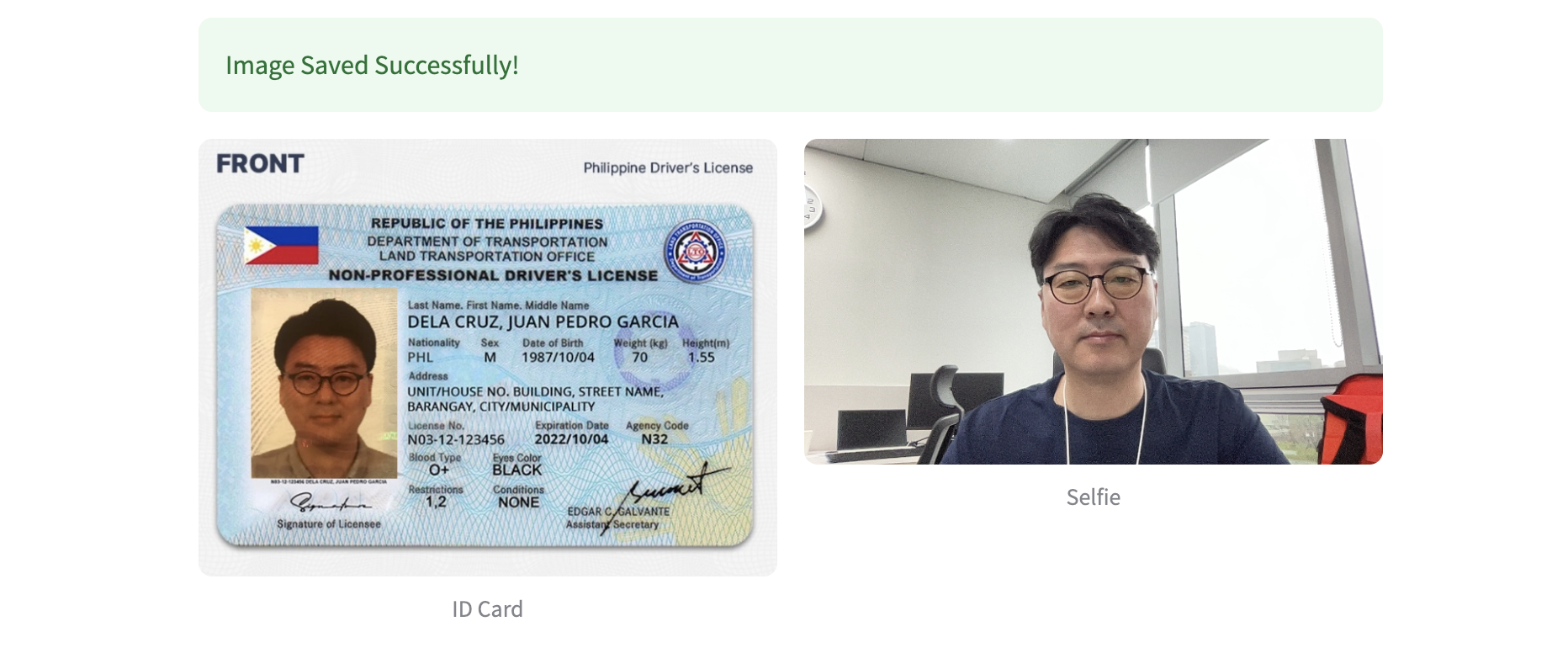

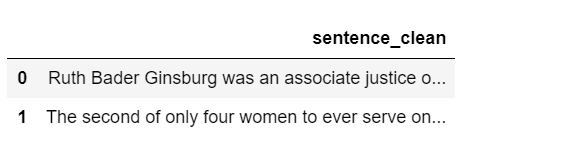

이번엔 표가 있는 이미지를 가지고 테스트 해보겠습니다.

>>> Describe the content of the given image ~/gemma3_prerequisites.jpeg

Added image '/Users/dongsik/workspace/ekyc/gemma3_prerequisites.jpeg'

The image is a table outlining the recommended GPU requirements for different model sizes (in billions of parameters) for a Text-to-Text model.

Here’s a breakdown of the information presented:

* **Parameters (Billion):** The table lists the model size in billions of parameters (1B, 4B, 12B, 27B).

* **VRAM Requirement (Text-to-Text):** This column specifies the amount of VRAM (Video RAM) needed to run the model for Text-to-Text tasks.

* **VRAM Requirement (Image-to-Text):** This column specifies the amount of VRAM needed to run the model for Image-to-Text tasks.

* **Recommended GPU:** This column lists the recommended GPU based on the VRAM requirement.

Essentially, it’s a chart showing the relationship between model size, VRAM requirements, and the corresponding GPU needed to run the model

effectively.

Do you want me to elaborate on any specific aspect of this table, such as the VRAM requirements for a particular model size or the GPU

recommended for a specific task?

>>>

>>> 주어진 이미지의 내용을 설명하세요. /Users/dongsik/workspace/ekyc/gemma3_prerequisites.jpeg

Added image '/Users/dongsik/workspace/ekyc/gemma3_prerequisites.jpeg'

다음은 이미지의 내용에 대한 설명입니다.

**표는 텍스트-투-텍스트 및 이미지-투-텍스트 작업에 필요한 GPU 사양을 나타냅니다.**

* **Parameters (Billions):** 모델의 파라미터 수를 나타냅니다.

* **VRAM Requirement (Text-to-Text):** 텍스트-투-텍스트 작업에 필요한 VRAM(비디오 RAM)의 양을 나타냅니다.

* **VRAM Requirement (Image-to-Text):** 이미지-투-텍스트 작업에 필요한 VRAM의 양을 나타냅니다.

* **Recommended GPU:** 주어진 파라미터 수에 맞는 VRAM 요구 사항을 충족하는 데 권장되는 GPU 모델을 나열합니다.

**주요 관찰 사항:**

* 파라미터 수가 증가함에 따라 텍스트-투-텍스트 및 이미지-투-텍스트 작업 모두에 필요한 VRAM 요구 사항이 크게 증가합니다.

* 더 큰 모델은 효율적으로 작동하기 위해 훨씬 더 많은 VRAM이 필요합니다.

이 표가 도움이 되었기를 바랍니다!

>>>

그럼 마지막으로 이미지에서 답을 찾아오는 질문을 해보겠습니다,

"그림에서 4B 모델을 image to text 하기위해 필요한 VRAM은 은 얼마인가요?" 네, 답은 10.4B 입니다.

결과를 보시죠.

>>> 그림에서 4B 모델을 image to text 하기위해 필요한 VRAM은 은 얼마인가요?

그림에 따르면 4B 모델을 image to text 하기 위해 필요한 VRAM은 10.4 GB입니다.

>>>

오....!!!

'AI > LLM-Gemma' 카테고리의 다른 글

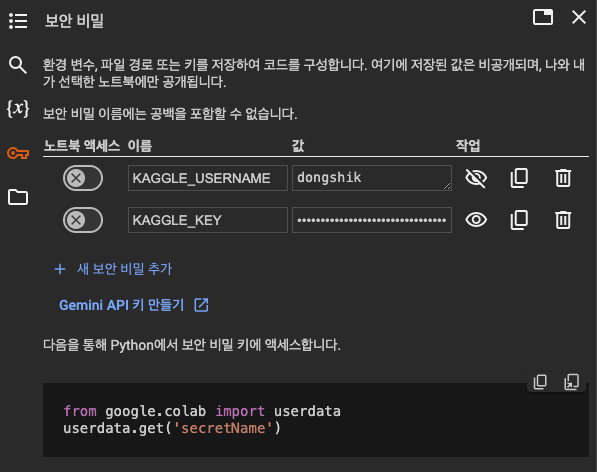

| Google Colab에서 Ollama를 사용하여 Gemma 모델을 실행 (0) | 2024.09.22 |

|---|---|

| Colab에서 T4 GPU 런타임설정 및 Kaggle Credential Key 설정 (0) | 2024.09.19 |

| Mac Intel CPU Ollama gemma2 (1) | 2024.09.06 |